Como instalar Ollama para otimizar modelos de machine learning com mais eficiência

O Ollama é perfeito para rodar grandes modelos de linguagem (LLMs) de forma segura no seu computador, garantindo a privacidade dos dados e reduzindo custos ao eliminar a dependência da nuvem. Ele é especialmente útil para setores que precisam de confidencialidade, como saúde e finanças, e ainda oferece suporte para personalizações de acordo com necessidades específicas.

Neste artigo, vamos te guiar pelo processo de instalação do Ollama, passo a passo. Você vai aprender como baixar o pacote de instalação do GitHub, instalar no seu VPS e fazer a configuração inicial para que tudo funcione direitinho.

E ainda tem mais: vamos te mostrar como esse tempo de configuração pode ser reduzido a basicamente zero usando os produtos da Hostinger.

Conteúdo

O que é Ollama?

O Ollama é uma plataforma de código aberto que permite rodar large language models (LLMs) ajustados localmente no seu computador. Ele suporta diversos LLMs populares, como Llama 2, GPT-3.5 e Mistral. Ao integrar capacidades de IA diretamente em suas aplicações, o Ollama aumenta a segurança, melhora a privacidade e oferece maior controle sobre o desempenho do modelo.

Com o Ollama, você pode gerenciar pesos de modelo, configurações e conjuntos de dados por meio de uma interface simples e intuitiva. Isso facilita a adaptação dos modelos de linguagem para casos de uso específicos. De muitas formas, ele é um verdadeiro sonho para desenvolvedores que gostam de fazer experimentos com inteligência artificial.

No entanto, se você quiser integrar a ferramenta nas suas aplicações web sem depender de APIs de terceiros, será necessário configurá-lo primeiro no seu ambiente de hospedagem. É isso que veremos a seguir.

Pré-requisitos para instalar o Ollama

Antes de iniciar o processo de instalação, você precisará de alguns itens para instalar o Ollama em seu VPS. Vamos dar uma olhada neles agora.

Hospedagem VPS

Para executar o Ollama com eficiência, você precisará de um servidor virtual privado (VPS) com pelo menos 16 GB de RAM, mais de 12 GB de espaço de armazenamento e de 4 a 8 núcleos de CPU.

Observe que esses são apenas os requisitos mínimos de hardware. Para obter uma configuração ideal, é necessário ter mais recursos, especialmente no caso de modelos com mais parâmetros.

Sistema operacional

O Ollama foi projetado para ser executado em sistemas Linux. Para obter os melhores resultados, seu ambiente de hospedagem deve rodar o Ubuntu 22.04 (ou superior) ou a versão estável mais recente do Debian.

Acesso e privilégios

Para instalar e configurar o Ollama, você precisa acessar o terminal ou a interface de linha de comando do seu VPS. Você também precisa ter acesso root ou possuir uma conta com privilégios sudo no Linux.

Como instalar Ollama usando um template de VPS da Hostinger

Agora que já falanmos sobre os pré-requisitos, vamos explorar como você pode instalar facilmente o Ollama no seu VPS usando um template pré-pronto da Hostinger.

A Hostinger simplifica o processo de instalação do Ollama fornecendo um template VPS Ubuntu 24.04 pré-configurado em qualquer um dos nossos planos de VPS, que saem por valores a partir de R$ 26.99/mês.

Ele vem com o Ollama, o Llama 3 e o Open WebUI já instalados — tudo o que você precisa fazer é selecionar o template, aguardar a conclusão do instalador automático e fazer login no servidor para verificar a instalação.

Veja o passo a passo:

- Faça login na sua conta da Hostinger e acesse o hPanel.

- Na barra lateral, clique em VPS e selecione o VPS desejado clicando em Gerenciar.

- Clique em SO e Painel → Sistema Operacional e busque por Ollama.

- Confirme e aguarde a conclusão da instalação.

- Faça login em seu VPS usando SSH para verificar a instalação.

É isso aí! Agora você deve estar pronto para começar a usar o Ollama em seu VPS da Hostinger para alimentar seus aplicativos da Web.

Como o template já tem todas as ferramentas e softwares necessários pré-instalados e configurados, você não precisa fazer mais nada para mergulhar nos LLMs.

Como instalar Ollama manualmente no VPS

Se você deseja rodar o Ollama no seu VPS, mas usar um provedor de hospedagem diferente, veja como instalá-lo manualmente. Esse processo é um pouco mais complexo do que usar um template pronto, então vamos te guiar por cada etapa.

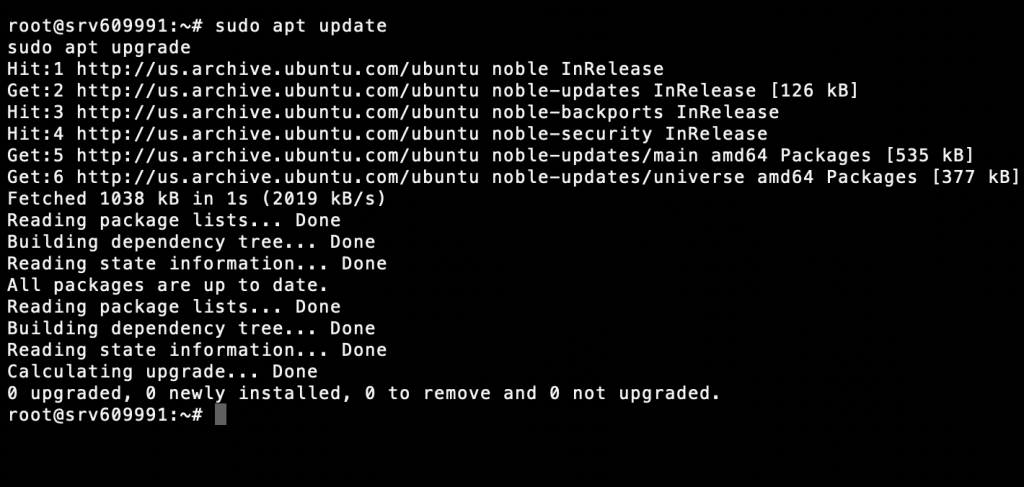

1. Atualize os pacotes do sistema

Você precisa ter certeza de que seu VPS está atualizado antes de instalar qualquer novo software. Para atualizar sua lista de pacotes e atualizar os pacotes de instalação, execute os comandos abaixo usando a linha de comando do seu servidor:

sudo apt update sudo apt upgrade

Manter seu sistema atualizado ajuda a evitar problemas de compatibilidade e garante uma instalação tranquila do início ao fim.

2. Instale as dependências necessárias

O Ollama requer algumas dependências para funcionar sem problemas, como as versões mais recentes do Python, Pip e Git. Para instalá-las, execute este comando:

sudo apt install python3 python3-pip git

Verifique se a instalação foi concluída com êxito executando:

python3 --version pip3 --version git --version

Se o seu VPS tiver uma GPU NVIDIA, você precisará de drivers CUDA adicionais para aproveitar o desempenho aprimorado da GPU. Mas essas etapas variam de acordo com a configuração de seu servidor. Siga o guia oficial da NVIDIA sobre o download do kit de ferramentas CUDA para saber mais.

3. Baixe o pacote de instalação do Ollama

Em seguida, faça o download do pacote de instalação do Ollama para Linux em seu site oficial. Você pode fazer isso executando:

curl -fsSL https://ollama.com/install.sh | sh

Isso fará o download e instalará o Ollama em seu VPS. Agora, verifique a instalação executando:

ollama --version

4. Execute e configure o Ollama

Agora você deve poder executar o Ollama sempre que quiser usando o seguinte comando:

ollama serve

Antes de prosseguir, você deve verificar o status atual do serviço Ollama executando isso na CLI:

systemctl status ollama

Se você é cliente VPS da Hostinger, também pode usar o Assistente de IA Kodee para confirmar se o Ollama já está em execução no seu servidor. No painel de controle do seu VPS, abra o menu do Kodee na barra lateral esquerda e digite um prompt como “Você pode verificar se o Ollama está em execução no meu servidor?”

Em seguida, crie um arquivo de serviço systemd para que o Ollama seja executado automaticamente toda vez que você inicializar o VPS:

sudo nano /etc/systemd/system/ollama.service

Adicione o seguinte conteúdo ao seu arquivo de serviço systemd:

[Unit] Description=Ollama Service After=network.target [Service] ExecStart=/usr/local/bin/ollama --host 0.0.0.0 --port 11434 Restart=always User=root [Install] WantedBy=multi-user.target

Depois disso, use o comando abaixo para recarregar o ambiente:

systemctl daemon-reload systemctl restart ollama

E pronto! O Ollama deverá ser iniciado automaticamente na próxima vez que você inicializar seu VPS.

Observação: ainda que ele ofereça várias opções de configuração para modificar o comportamento do modelo, ajustar o desempenho e alterar as configurações do servidor, o Ollama foi projetado para funcionar perfeitamente com sua configuração padrão, logo após a instalação.

Essa configuração funciona bem para a maioria dos cenários, portanto, você pode começar imediatamente a buscar os arquivos de modelo necessários. Você pode fazer isso executando “ollama pull <model_name>”.

Conclusão

Agora que você instalou o Ollama com sucesso no seu VPS, tem acesso a diversas ferramentas para ajustar uma variedade de modelos de linguagem grandes antes de rodá-los localmente no seu servidor. O Ollama abre um mundo de possibilidades para desenvolvedores, pesquisadores e entusiastas de IA.

Alguns dos casos de uso mais comuns do Ollama incluem a criação de chatbots personalizados e assistentes virtuais para atender a necessidades específicas. Por exemplo, você pode criar seu próprio assistente de programação para ajudar no desenvolvimento de aplicativos web e móveis, criar um parceiro para brainstorming em projetos de design, usar modelos de tradução de texto ou explorar as possibilidades dos modelos de linguagem natural em estratégias e criação de conteúdo.